看起来是从图像角度进行计算,和vit原理差不多,都是将图像切成小块,每一个小块可以近似看为一个向量,注意力的计算也是基于这些向量进行的,二维的图像转为一维的向量进行训练学习。

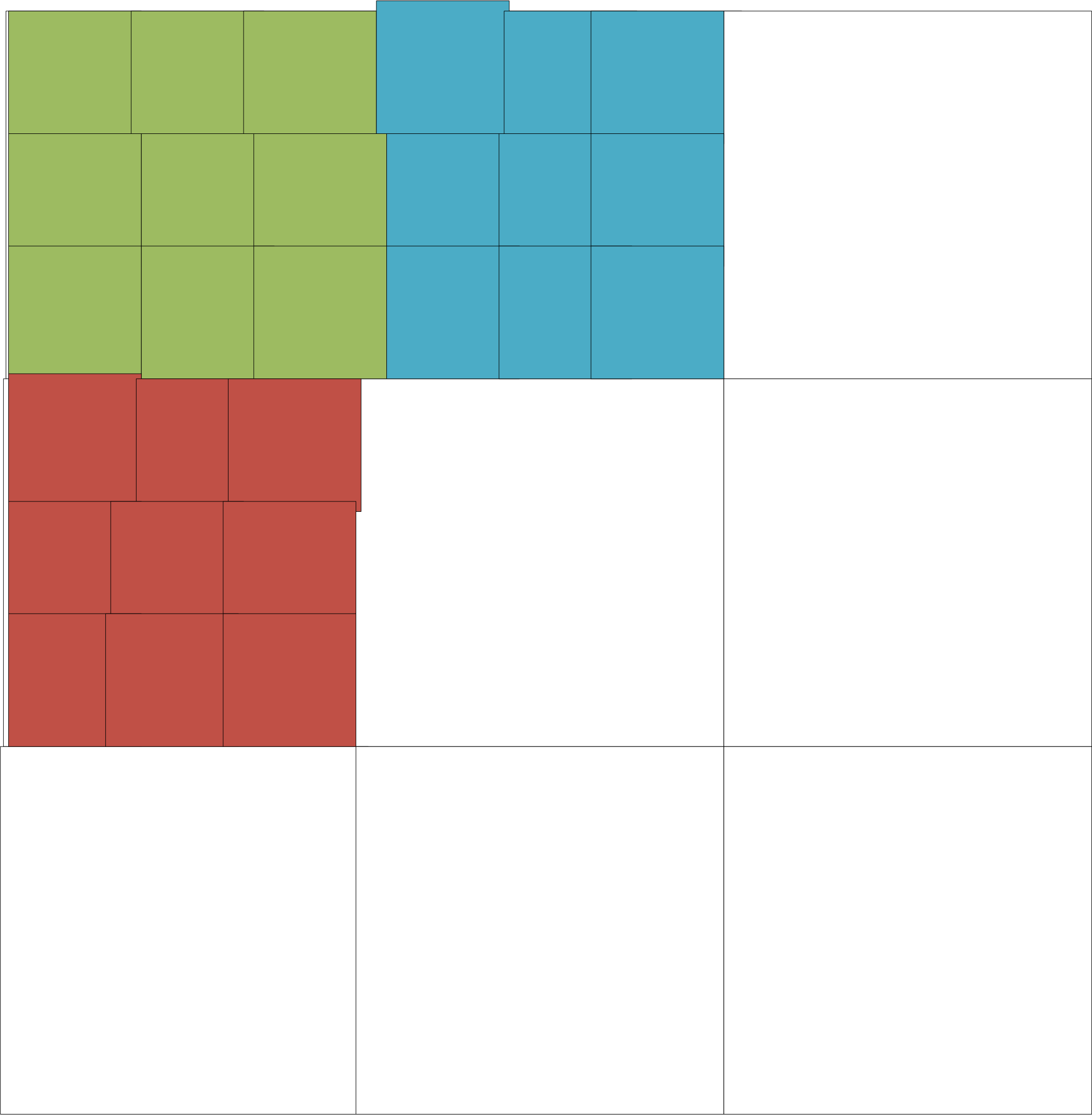

全局自注意力机制,所有的token都可以相互联系起来,但这样计算量会特别特别大。Swin Transformer通过窗口(Window)来限制自注意力的范围,计算量就小很多, 简单来说,Swin Transformer把图像分成了很多个小窗口(Window),然后每个窗口里面的token只和窗口里的其他token互相作用。不过,如果窗口一直不动,每个窗口之间的token就不会交进行注意力的交互,这样会缺少全局信息(不够全局,在窗口内还是全局的)。所以, Swin Transformer就会每隔一层,移动一下窗口的位置(Shift Window),让这些窗口错开一部分。这样,原来在不同窗口里的token,就可以通过这次移动的窗口进行注意力的交互达到理论上的全局注意力机制。