self attention模块输入输出都可以看作是向量

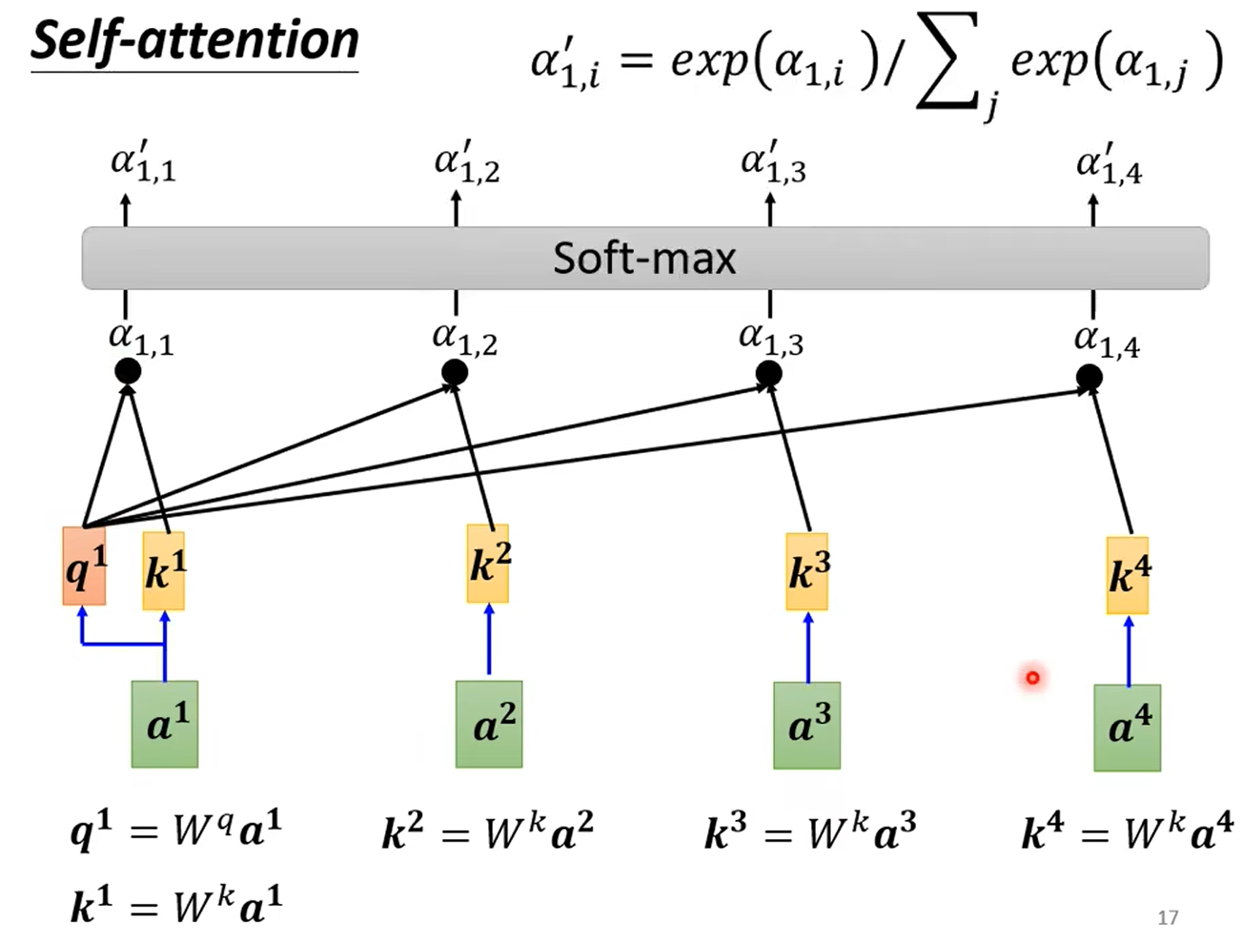

每个向量都要和其他向量在self attention模块中进行交互

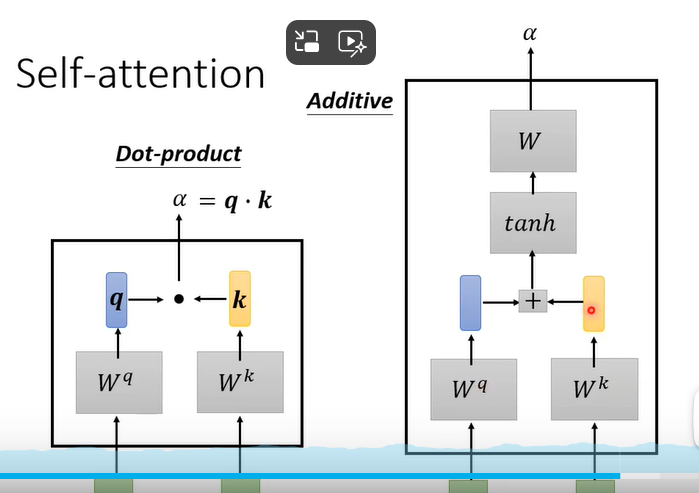

以下是两种两个向量之间交互的方法

一个向量和sequence中其他向量交互(两个向量之间交互的拓展),输出即为相关度

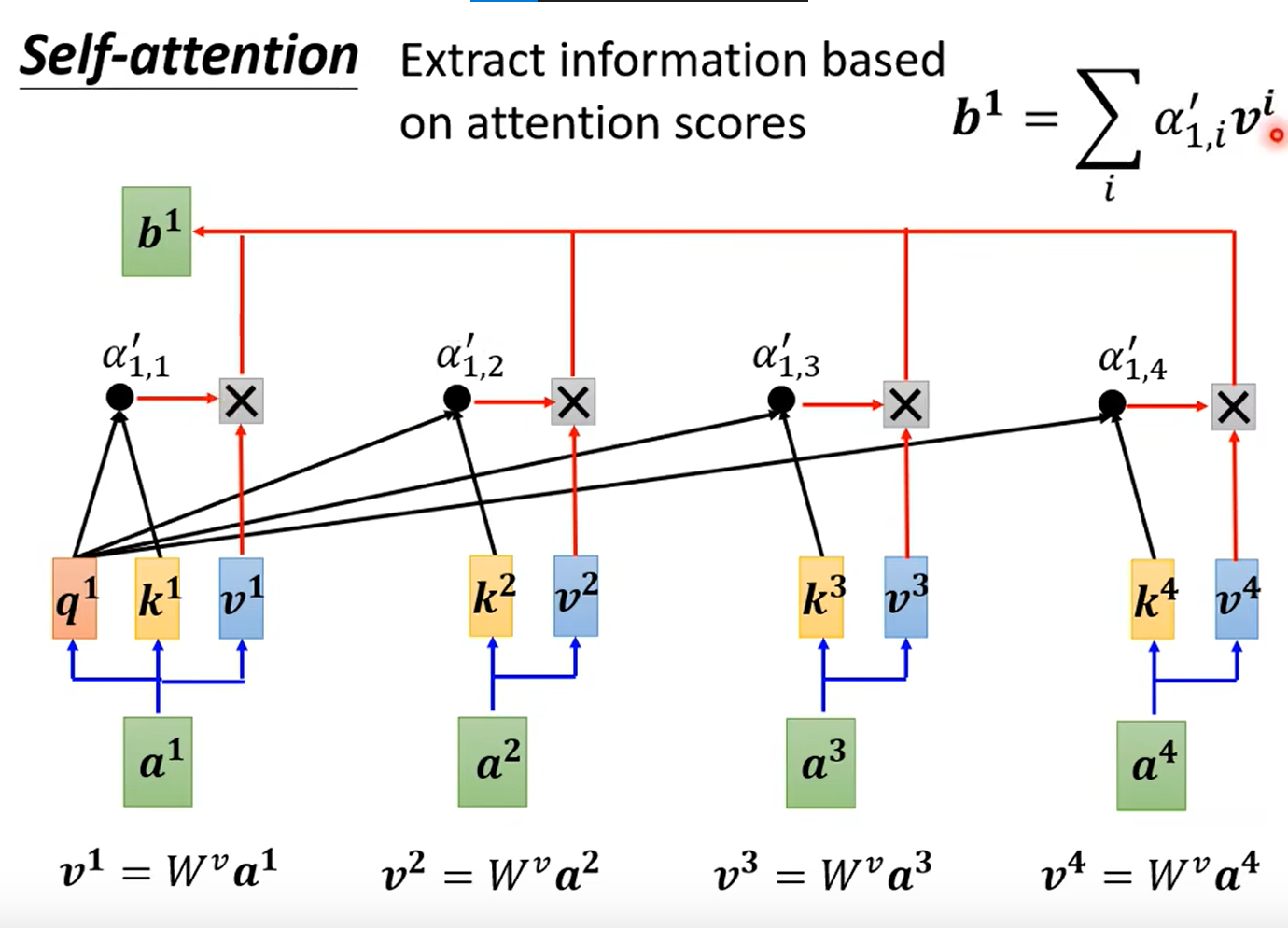

计算与输入位置对应的输出向量(考虑了其他所有向量的信息,在这里哪个向量的alpha更大,即相关性强,计算输出向量的求和那里对相关性强的输入向量对应的V矩阵系数乘的也越多)

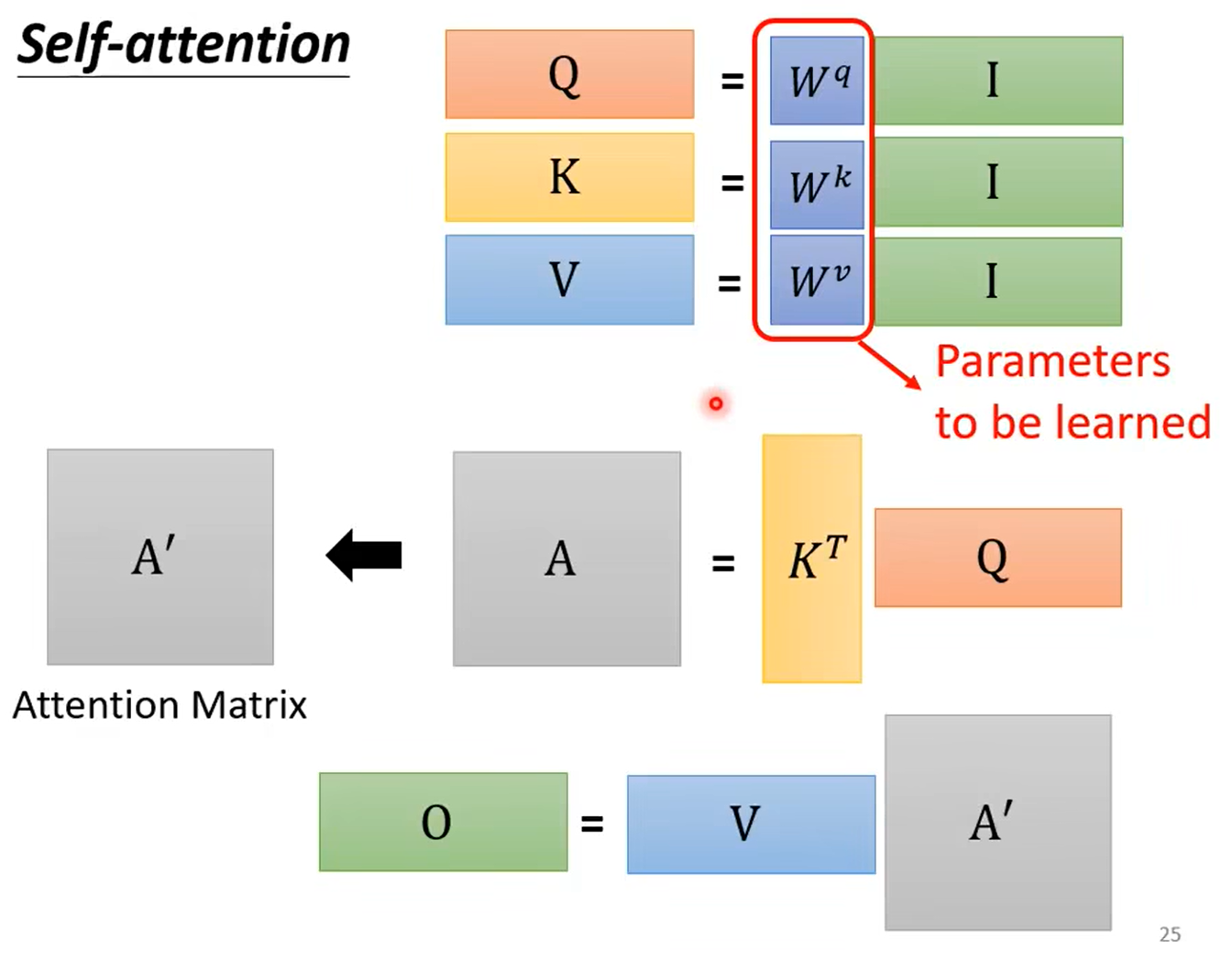

这个self attention模块充分利用了GPU的并行能力,所有的操作都可以整合到矩阵计算中并行计算。